Übersicht

Die Ergebnisse und Zwischenergebnisse der in diesem Projekt durchgeführten Arbeiten und entwickelten Methoden werden in diesem Abschnitt näher erläutert. Analog zur inhaltlichen Unterteilung der geplanten Inhalte erfolgt die Beschreibung der dort erzielten Ergebnisse:

- Umrechnung von Lärmquellenmessungen in passende Schallprofile

- Automatische schallphysikalische Erfassung der Umgebung (Nah- und Fernbereich)

- Berechnung der Schallausbreitung anhand der Schallprofile und der Umgebungsdaten

- Interaktive visuelle und akustische Darstellung der Berechnungen mittels AR (virtuelle Lärmquelle mit virtuellem Schall in realer Umgebungen)

- Umgebungserkennung und ferne 3D scanning

Die eben aufgelisteten Arbeiten werden nochmals in Subtasks aufgeteilt sowie deren Status (abgeschlossen, in Bearbeitung) unterteilt.

Umrechnung von Lärmquellenmessungen in passende Schallprofile

Zum erfolgreichen Abschluss der geplanten Arbeiten wurden folgende Schritte unternommen:

- Entwicklung eines geeigneten Testaufbaus zur richtungs- und frequenzaufgelösten Erfassung der Schallprofile unterschiedlicher Lärmquellen (abgeschlossen)

- Definition und Bezug geeigneter Lärmquellen (abgeschlossen)

- Vermessung der Lärmquellen (abgeschlossen)

- Aufbereitung der Schalldaten (abgeschlossen)

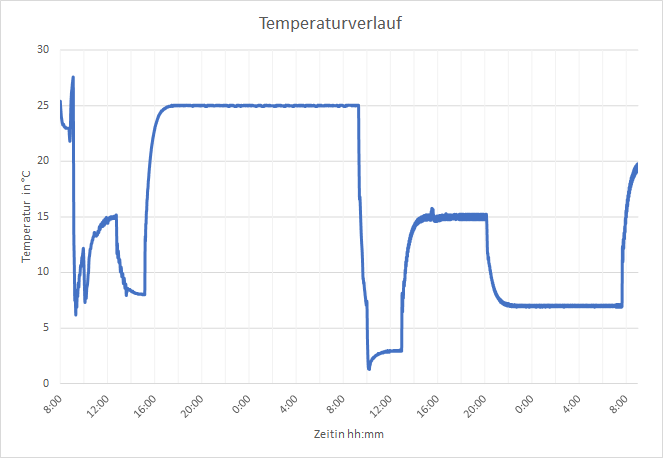

Die Schallausbreitung unterschiedlicher Schallquellen unterscheidet sich neben den gewählten Quellen und deren Bauform auch von klimatischen Randbedingungen. Um Messwerte für eine geeignete Anzahl an realistischen Bedingungen unterschiedlicher Temperaten und Feuchten zu erhalten, werden Klimakammern genutzt, in denen ebensolche bereitgestellt werden können. Beispielhafte Ergebnisse für solch einen Temperatur- und Feuchteverlauf ist in Abbildung 1 dargestellt.

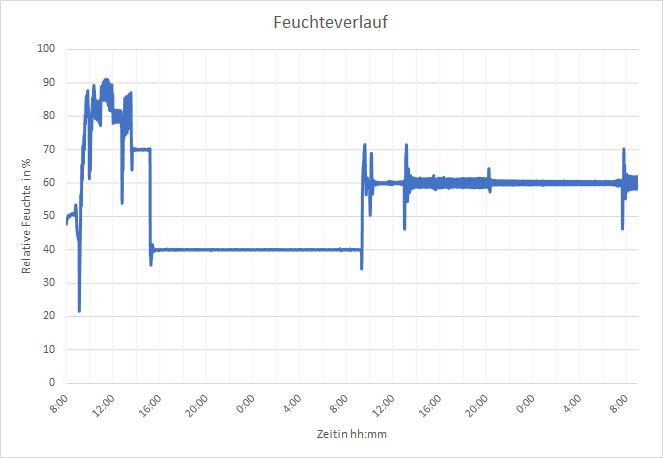

In diesen Kammern wird ein sogenannter akustischer Dom aufgebaut, um Schallprofile unterschiedlicher Lärmquellen richtungs- und frequenzaufgelöst aufnehmen zu können. Dabei werden um die jeweilige Schallquelle 64 Mikrophonhalterungen mit klar definierten Abständen platziert. Die Halterungen wurden im Anschluss mit kalibrierten Mikrophonen bestückt und am Datenerfassungsmodul angeschlossen. In Abbildung 2 ist dieser Aufbau ersichtlich.

Zur Evaluierung der Mess- und der anschließenden Berechnungsmethoden wurden drei Lärmquellen mit unterschiedlichen Eigenschaften ausgewählt:

- Referenzschallquelle

- Beweglicher Dodekaeder

- Wärmepumpenaußeneinheit

Die Referenzschallquelle wurden zur Bestimmung des Einflusses der Temperatur und Luftfeuchte auf die Messeigenschaften der Mikrofone und zur Kalibrierung des Systems gewählt. Als Alternative zur Referenzschallquelle, die aufgrund ihrer Bauweise eine Luftströmung im Messbereich erzeugt, wurde ein Dodekaeder-Lautsprecher-Messsystem eingesetzt. Um die Richtcharakteristik auszugleichen, wurde der Dodekaeder motorisch drehbar aufgebaut. Die Methoden zur Messdatenaufbereitung wurden final mit den Ergebnissen einer vermessenen am Markt befindlichen Wärmepumpenaußeneinheit getestet und evaluiert.

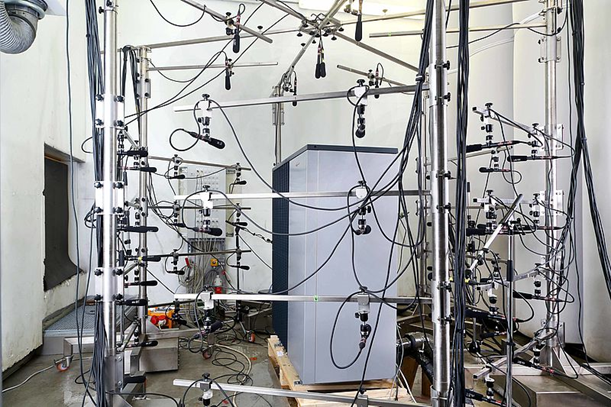

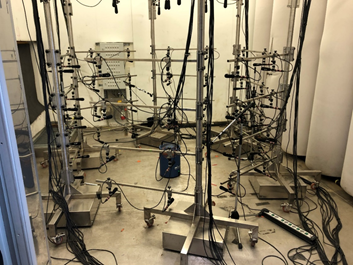

Die gewählten Schallquellen wurden nacheinander unter denselben Bedingungen vermessen. Abbildungen der Aufbauten der Referenzschallquelle und des beweglichen Dodekaeders sind in Abbildung 3 zu sehen.

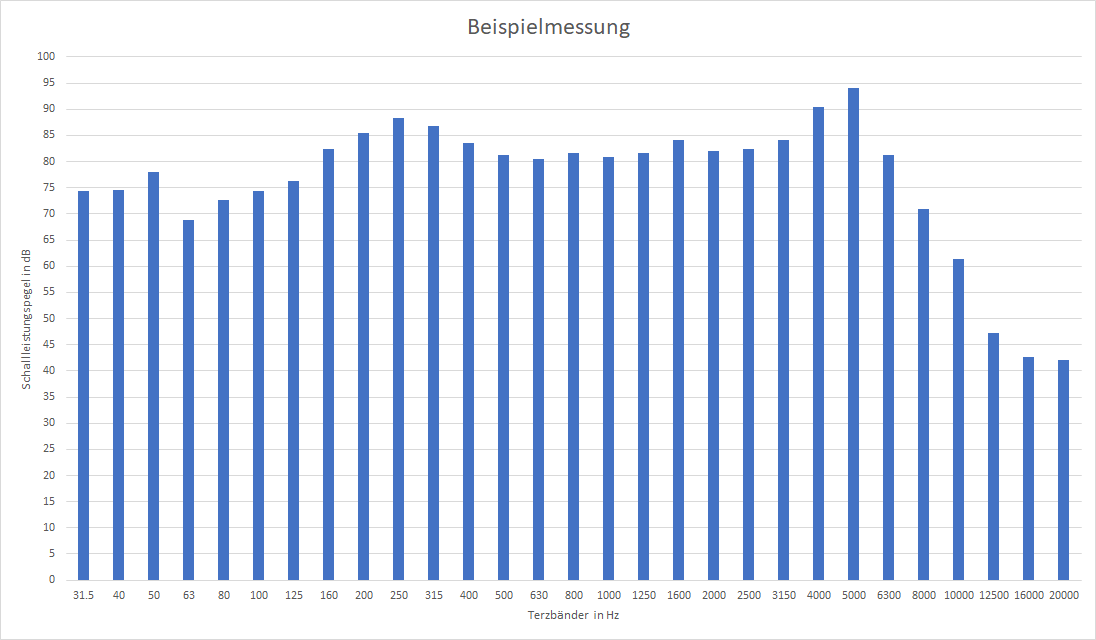

Die erfassten Messdaten werden in weiterer Folge für jedes Mikrophon aufbereitet und in Terzbänder unterteilt. Dadurch ergibt sich die gewünschte richtungsabhängige (durch die 64 vermessenen Mikrophone) und die frequenzabhängige (durch die Berechnung der Schallleistungspegeln über die relevanten Terzbänder) Auflösung des jeweiligen Schallemitters. Diese Daten können in weiterer Folge den Schallberechnungsmethoden übergeben und die ortsabhängigen Schallleistungspegeln berechnet werden. Das Ergebnis einer beispielhaften Messung ist in Abbildung 4 dargestellt.

Automatische schallphysikalische Erfassung der Umgebung (Nah- und Fernbereich)

Die Erfassung der Umgebung erfolgt in drei aufeinanderfolgenden Schritten:

- Einlesen vorhandener CityGML Daten (abgeschlossen)

- Erfassung des Nahbereichs (abgeschlossen)

- Erfassung des Fernbereichs (in Bearbeitung)

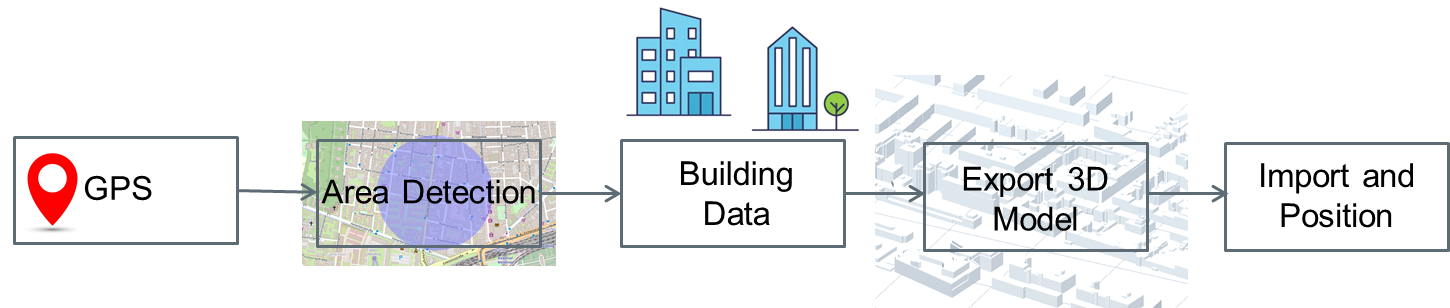

Um den Aufwand der Erkennung der gesamten Umgebung zu reduzieren, wird auf bereits vorhandene Umgebungsdaten zurückgegriffen, sofern diese verfügbar sind. Diese liegen in Form von CityGML Daten für weltweit viele Gebiete – in erster Linie für Städte – vor. Eine Einbindung in AR ist in Abbildung 5 schematisch dargestellt.

Dabei erfolgt über die Auswahl der relevanten Geometrien basierend auf GPS-Koordinaten in einem Radius um die abgefragte Position, eine Extraktion dieser Geometrien aus CityGML Datenbanken und einem Export als .obj Datei, die sich mit den Ergebnissen der nachfolgenden Identifikationsalgorithmen kombinieren lässt.

Nach dem Import etwaiger CityGML Daten wird der Nahbereich detektiert. Die Detektion beinhaltet Ergebnisse aus bildgebenden Verfahren und der Nutzung von Sensoren (z.B. ToF). Durch diese Kombination werden Punktwolken erstellt und durch bestehende Algorithmen werden horizontale sowie vertikale Flächen identifiziert, siehe Abbildung 6.

Diese Identifikation ist notwendig, um eine Basis für virtuell platzierbare Objekte zu schaffen. Die so erhaltenen visuellen Informationen werden mit Messungen der IMU (Inertiale Messeinheit) des Geräts kombiniert, um die Lage (Position und Ausrichtung) der Kamera im Verhältnis zur Welt über die Zeit zu abzuschätzen. Die Ergebnisse werden mit jenen von CityGML kombiniert und ein erster Schritt der Umgebungserkennung ist abgeschlossen.

Im Zuge der Analyse und Implementierung von Methoden zur Erfassung des Nahbereichs wurde festgestellt, dass diese Methoden für die Erfassung des Fernbereichs nur bedingt nutzbar sind. Dabei limitieren vor allem die verbauten Sensoren, welche meist nur einen Bereich von 3-5m abdecken können. Derzeit befinden wir uns in der Analysephase geeigneter Methoden und benötigter Adaptierungen bzw. Neuentwicklungen von Methoden zur Erfassung des Fernbereichs.

Berechnung der Schallausbreitung anhand der Schallprofile und der Umgebungsdaten

Die Berechnung der Schallausbreitung ist in zwei Bereiche unterteilt:

- Richtungsabhängige Schallberechnung (abgeschlossen)

- Schallberechnung unter Einbeziehung von Reflexion, Absorption und Beugungseffekten (in Bearbeitung)

Für beide Berechnungsmethoden werden jene Informationen benötigt, die in den Kapiteln Umrechnung von Lärmquellenmessungen in passende Schallprofile und Automatische schallphysikalische Erfassung der Umgebung (Nah- und Fernbereich) ermittelt wurden:

- Punkte der im Raum ermittelten Objekte

- Ecken der im Raum ermittelten Objekte

- Flächen der im Raum ermittelten Objekte

- Schallrelevante Parameter der im Raum ermittelten Objekte

- Position und Ausrichtung der Schallquellen

- Richtungs- und frequenzaufgelöste Schallleistungspegel der Schallquellen

All diese Informationen werden im JSON Format an die Berechnungsalgorithmen übergeben und die raumaufgelösten Schalldruckpegel in demselben Format an die Software rückgespielt.

Für die Berechnung der gerichteten Schallausbreitung wird die Charakterisierung der Quelle mittels eines Multipols und die Ausbreitungsberechnung mittels der BEM Methode durchgeführt. Dabei werden sowohl die Dom-Messungen als auch Schallintensitätsmessungen aus Umrechnung von Lärmquellenmessungen in passende Schallprofile genutzt. Ein wesentlicher Schritt der gerichteten Schallausbreitungsberechnung ist die Ableitung der Multipolquellen. Dafür wurden zwei Module implementiert:

- Modul 1 liest die Geometriedaten und die WAVE Dateien, die durch die Messungen zur Verfügung gestellt wurden, ein.

- Modul 2 liest die Tabellen mit den Teilleistungen der Maschine ein.

Die 2.5D BEM Software erlaubt neben Monopolen auch die Verwendung von Dipolen. Die BEM Software nutzt ein an NASTRAN angelehntes Eingabeformat, welches auf das Format JSON umgestellt wurde, um die Kommunikation mit den restlichen Methoden zu ermöglichen. Die Simulation mit einer HRTF (SOFA) steht unter Octave zur Verfügung.

Der erste Schritt der Simulation von Schalldaten ist die Bestimmung einer gerichteten Schallquelle aus den Messdaten. Dazu wurden zwei Linien untersucht: Der erste Fall beruht auf Schalldruckmessungen am akustischen Dom und der zweite Fall auf Schallintensitätsmessungen an einem Quader, der um die Wärmepumpe herum definiert wird. Wesentlich im Weiteren sind die Ausbreitungsfunktion des Schalldrucks eines Monopols und der drei Dipole. Für die Schallintensität werden zusätzlich die Ausbreitungsfunktionen der Schallschnelle benötigt. So entspricht die Schallschnelle des Monopols den Dipolfunktionen des Schalldrucks und die Schallschnelle des Dipols den Quadropolfunktionen des Schalldrucks.

Interaktive visuelle und akustische Darstellung der Berechnungen mittels AR

Im Projekt wird ein Prototyp entwickelt, der die in den letzten Kapiteln beschriebenen Funktionen zusammenfasst und interaktiv nutzen lässt. Folgendermaßen sind die Schritte zu setzen, um ein schallemittierendes Gerät virtuell zu platzieren und sich dessen Schallausbreitung anzeigen zu lassen:

- Identifikation der Umgebung

- Platzierung der virtuellen Objekte (Schallquellen, Wände)

- Berechnung der Schallausbreitung

Einen Überblick über die unterschiedlichen Funktionen gibt folgende Darstellung:

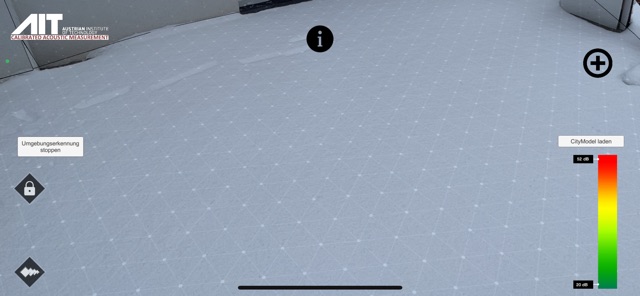

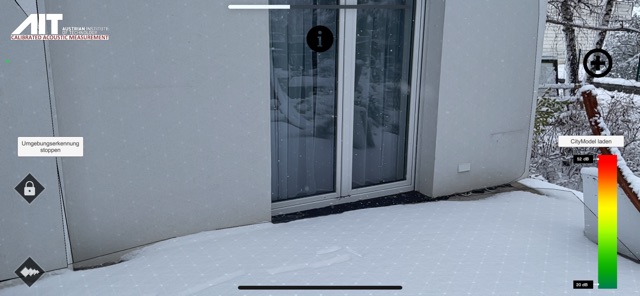

Links ist die Option zu erkennen, um die Umgebungserkennung zu deaktivieren. Dies kann nützlich sein, wenn alle relevanten Objekte identifiziert und die Schallquellen bereits platziert wurden, da dadurch Rechenleistung gewonnen und etwaige Mehrfachidentifikationen vermieden werden können. Ein Ergebnis der Umgebungserkennung ist in Abbildung 8 ersichtlich. Hierbei erkennt die Software eine horizontale und zwei vertikale Ebenen, welche in Abbildung 9 als punktierte graue Flächen ersichtlich sind.

In Abbildung 9 sind rechts zwei Symbole zu sehen, wobei das linke eine Liste der in der Datenbank gespeicherten Lärmquellen anzeigt und das rechte eine virtuelle Wand platzieren lässt. In der Datenbank sind sowohl die graphischen Modelle der Lärmquellen als auch deren Schalleigenschaften gespeichert. In Abbildung 9 ist das Endergebnis der Umgebungserkennung, die Platzierung virtueller Objekte und die Darstellung der Schallausbreitung zu sehen.

All die entwickelten Methoden wurden seitens des AITs auf Eigenkosten in einer kostenlosen App veröffentlicht, die sowohl im AppStore als auch im PlayStore als Download zur Verfügung steht. In dieser App werden alle Funktionen integriert, die bei internen Tests eine geeignete Qualität vorweisen. Bis dahin bleiben entwickelte Methoden zu Testzwecken im internen Prototyp bestehen. Darunter fallen:

- Umgebungserkennung (Fernbereich)

- Zuweisung schallrelevanter Eigenschaften (Datenbank)

- Berechnung der gerichteten Schallausbreitung

- Berechnung der gerichteten Schallausbreitung inkl. Reflexionen und Absorptionen

- Auswahl der Visualisierungsart der Schallberechnungsergebnisse

- Hörbarmachung des Schalldruckpegels

Diese Funktionen werden nach ihrer Entwicklung und erfolgreich abgeschlossener Testung vom Prototyp in die kostenlose App überführt.

Umgebungserkennung und ferne 3D scanning

Bei dem RAARA Projekt ist die ARCore Flächenerkennung an ihr Limit gestoßen, und die Qualität der erkannten Flächen und 3D Objekte in größere Entfernung war nicht zufriedenstellend. Während des Projekts hat sich also herauskristallisiert, dass die von diesen APIs zur Verfügung gestellten Funktionen nicht für die gewünschte Anwendung ausreichend sind. Deswegen haben wir die semantische Segmentierung und Stereo Vision selbst implementiert.

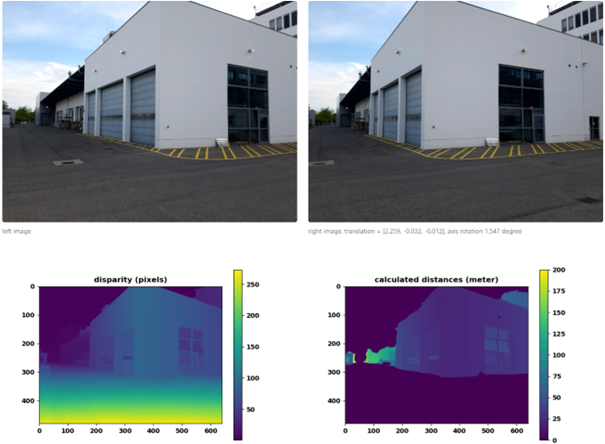

Wir haben zuerst ein Unity Programm für Android geschrieben, mit welchem wir Stereoaufnahmen (records) aufnehmen können. Das Programm speichert per Kopfdruck nicht nur die Bilder, sondern auch die aktuelle Kameraposition und -rotation in einer Datei auf dem Smartphone. Auf diesen Stereoaufnahmen werden dann verschiedene Stereoberechnungen getestet und verglichen. Methoden hierfür sind z.B. die klassische SGBM Methode oder die neuartige auf neuronalem Netzwerk basierende RAFT-Stereo Methode. Die 3D Punktwolke berechnen wir von der Depth-Map mit der Camera Matrix. Die 3D Punktwolke wird mit Hilfe von open3d und dem pyvista python Packages zu einem 3D Standardformat (.gltf) konvertiert. Ein Beispiel für die AIT-Gebäude sind in der folgenden Abbildung zu sehen.

Für mehr Beispiele siehe unser 3D stereo-scanning demo site .